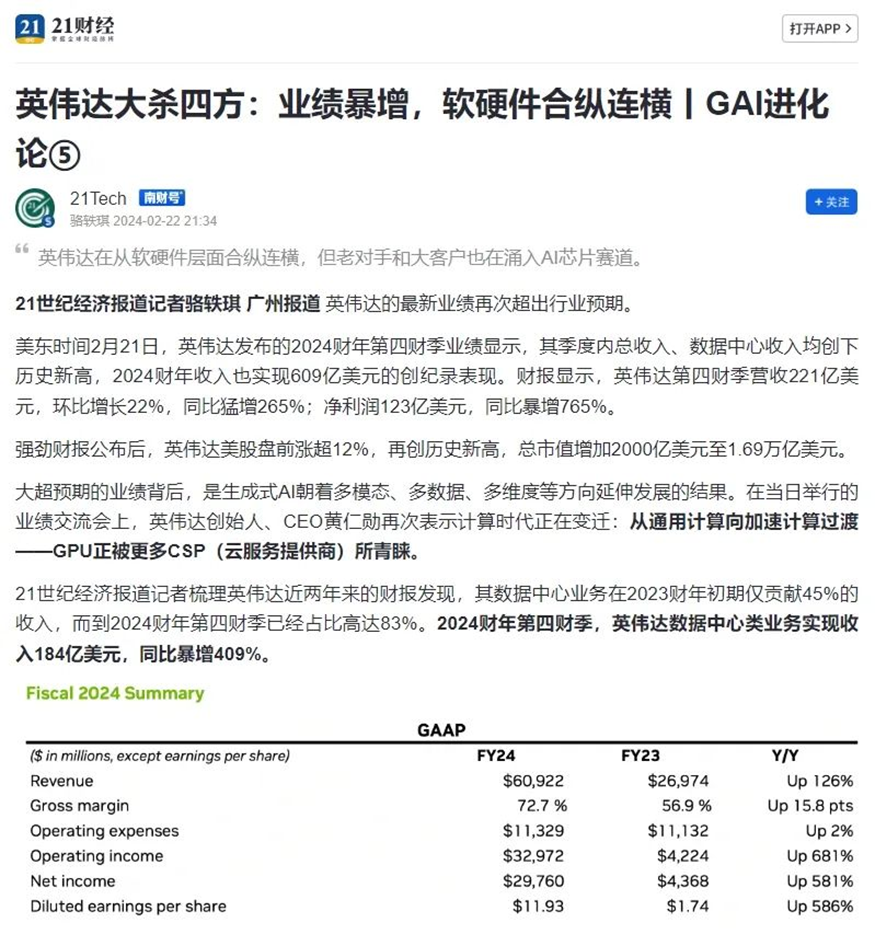

美东时间2月21日,英伟达发布的2024财年第四财季业绩显示,其季度内总收入、数据中心收入均创下历史新高,2024财年收入也实现609亿美元的创纪录表现。财报显示,英伟达第四财季营收221亿美元,环比增长22%,同比猛增265%;净利润123亿美元,同比暴增765%。近期有消息显示,在既有优势GPU领域之外,英伟达正在准备进入ASIC领域与博通竞争。从GPU进入ASIC领域是否存在较大门槛?英伟达的新动向意味着什么?在大模型旺盛需求下,GPU之外的TPU、LPU等路线兴起意味着高速计算芯片的新可能吗?这几条路线有什么优劣势?

弗若斯特沙利文(Frost & Sullivan,以下简称“沙利文”)大中华区合伙人兼董事总经理陆景接受21世纪经济报道采访,共同探讨上述话题。

21世纪经济报道

*点击文末阅读原文,查阅完整报道

Q: 近期有消息显示,在既有优势GPU领域之外,英伟达正在准备进入ASIC领域与博通竞争。您怎么看从GPU进入ASIC领域是否存在较大门槛?英伟达的新动向意味着什么?

对人工智能的实现来说,算法是核心,计算、数据是基础。对于计算能力来说,目前主要是使用GPU并行计算神经网络,同时,ASIC也在近几年逐渐成为更受欢迎的选择。ASIC (Application Specific Integrated Circuits,专用集成电路),是指应特定用户要求或特定电子系统的需要而设计、制造的集成电路。ASIC作为集成电路技术与特定用户的整机或系统技术紧密结合的产物,与通用集成电路相比,具有体积更小、功耗更低、可靠性提高、性能提高、保密性增强、成本降低等优势。不同于GPU 和FPGA 的灵活性,定制化的ASIC一旦制造完成将不能更改,所以初期成本高、开发周期长的使得进入门槛高。

英伟达作为全球占主导地位的人工智能芯片设计商和供应商,准备进入ASIC领域是旨在占领定制人工智能芯片爆炸性市场的一部分,并保护自己免受越来越多寻求其产品替代品的公司的影响。英伟达向ASIC领域的进军很可能蚕食博通和美满在ASIC领域的市场份额。

Q: 英伟达近期还推出Chat With RTX,这似乎主要是面向AI PC应用市场的一款产品。此前好像比较少见到英伟达面向应用端有这种动作,您怎么看英伟达此次的新动作?

Chat With RTX是一款个性化AI聊天机器人,它可以在PC本地运行,实现处理视频、分析文件,并为使用者提供基于自有数据的相关答案等功能。

自ChatGPT大火之后,OpenAI创始人山姆·阿尔特曼正在计划筹集大量资金投入AI芯片产业,旨在解决AI芯片的供需问题。英伟达此次的新动作是以实际行动回应其作为AI芯片行业的先锋者在大模型领域的能力,并将采用软硬结合的战略布局AI市场。

Q: 近期一个新鲜面孔Groq横空出世,采用LPU的方式与GPU计算模式进行竞争,据称借助SRAM而非HBM令计算速度非常快。根据目前释放的信息,您怎么看在大模型旺盛需求下,GPU之外的TPU、LPU等路线兴起意味着高速计算芯片的新可能吗?这几条路线间有什么优劣势?

Groq的LPU(Language Processing Unit)可以在更低功耗的同时带来更高的计算速度。抛开模型的准确度因素,LPU在特定领域的计算速度与目前广泛使用的GPU相比可以快10倍以上。LPU、TPU等高速计算芯片的兴起意味着AI大模型的落地将进一步加速。

TPU、LPU和GPU最大的差别是他们的架构和应用领域。GPU适用于通用计算任务,具有并行计算能力和大规模程序缓存的功能,如图形渲染、物理模拟和数值计算等。而LPU和TPU专注于深度学习和机器学习的加速应用,在特定领域功耗更低。使用者可根据不同的计算任务需求,选择合适的处理器来提高计算性能和效率。考虑到实际运行的综合成本因素,通用性能更强的GPU仍是训练大模型的首选。

Q: 越来越多大模型厂商(如谷歌、微软、Open AI等)选择/考虑准备自研AI芯片,加上老对手AMD的虎视眈眈。您认为这是否可能加速改变英伟达的统治地位(比如走向一超多强态势)?如果不能,主要的制约在哪里?

大模型的爆火推动英伟达成为当今讨论度最高的AI芯片公司,其年报所披露的营收及净利润也再创新高。但随着AI热潮持续升温,越来越多的大模型开始在AI芯片领域发力,想要早日摆脱英伟达的供给约束。大模型厂商想将AI运算的体量大幅度提升,就需要自家的芯片来支撑,这样才能达到最优的研发效率,因此越来越多的大模型厂商选择自研AI芯片。另一方面,AMD也在23年的12月推出了AI芯片,展开与英伟达的正面竞争。

然而,这些厂商短期内并不能撼动英伟达的统治地位。首先,英伟达拥有无可争议的先发优势和丰富的行业经验,其芯片已经被广泛应用在各大大模型厂商中;其次,英伟达构建了完善的CUDA生态,CUDA是英伟达推出的基于GPU的并行计算平台和编程模型,可以用来加速大规模数据并行计算,使得GPU可以用于更加广泛的科学计算和工程计算等领域。经过多年的建设,英伟达的CUDA已经有400万开发者,基本形成了垄断态势的生态壁垒,而软件生态恰恰是下游客户最为重视的产品竞争要素。如果贸然更换生态,意味着厂商学习成本、试错成本、调试成本都会增加。不仅如此,英伟达还通过投资的方式进一步巩固了自己的护城河,2023年以来,英伟达已投资了二十多家公司,包括从价值数十亿美元的大型新人工智能平台到将人工智能应用于医疗保健或能源等行业的小型初创企业,这些企业都与英伟达构成了紧密的联系。

对于大模型公司自研芯片,最重要的瓶颈在于供应链的问题无法在短期内解决,代工厂和晶圆厂产能已经饱和,在考虑综合成本的情况下,自研AI芯片并不一定从外部采购更具优势。对于AMD的AI芯片,英伟达的AI芯片更适配资金充沛且性能要求高的潜在客户。短期内,英伟达CUDA生态仍然稳健,大多数需要训练芯片的用户仍然会选择英伟达。

* 本采访刊登于 21财经 ,记者为骆轶琪,原文标题为:《 英伟达大杀四方:业绩暴增,软硬件合纵连横丨GAI进化论⑤》